会愤怒会奔跑,会冥想会思考!AI开始「拥有」七情六欲?曾被千万人表白“我等你长大”,如今她27岁长成这样,网友:告辞了

编辑 / Panda

人工智能如何拥有人类一样的喜怒哀乐?这篇文章给出新方向。

数月前,斯坦福大学和谷歌的联合研究团队发表的一篇题为《生成式智能体:人类行为的交互式模拟》(Generative Agents:Interactive Simulacra of Human Behavior)的研究论文,提出了AI智能体的概念。

近日,一项名为 Humanoid Agents 的人工智能系统再度引起了学术界和公众广泛的关注。

不同于以往发布的智能体模拟只能不完全地模仿人类行为,不能真正反映出人类的基本需求、真实情感及人际间微妙的距离感,Humanoid Agents可以更像人类一样行动和交流。

目前,这篇论文已被EMNLP System Demonstrations 2023接收,研究人员分别来自英伟达,华盛顿大学和香港大学。

研究方法

想让AI智能体更像人,就得按照人的元素来设定它。

人类在一天的活动中并不会完全按照计划做事,而是会适时地做出调整,所以让AI智能体完全按照提前指定的计划执行并不符合实际情况。

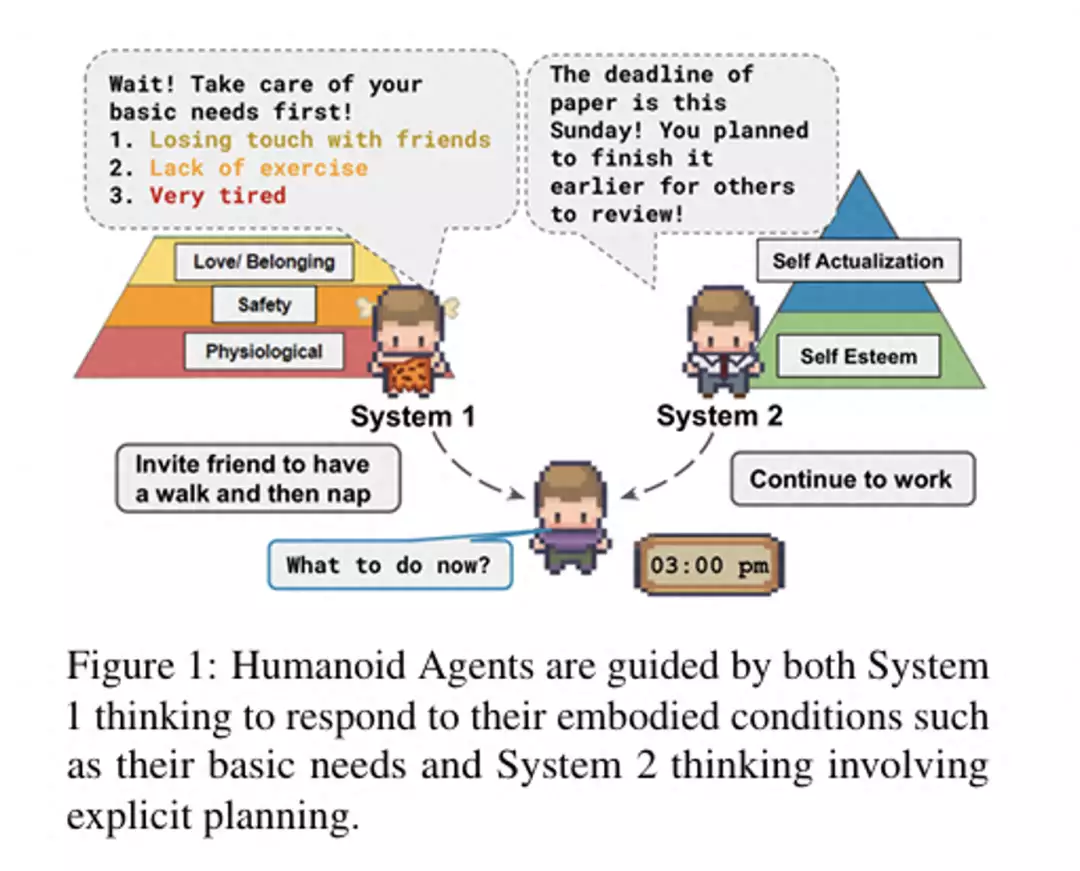

为此,研究人员通过模拟人类的系统1思维(直觉和情感驱动)和系统2思维(逻辑和计划驱动),使AI智能体更加人性化。

图1:仿人代理既要遵循系统1的思维方式来应对自身的具体情况,如基本需求,也要遵循涉及明确规划的系统2的思维方式

AI智能体的系统1思维受3个方面的影响,分别是基本需求(马斯洛需求)、情感和社会关系。这可以让AI智能体可以进行情境调整,而不只是预设计划。

基本需求是驱动智能体行为的最基本的因素,它们会影响智能体的目标、动机和行动选择。AI智能体需要与他人互动、保持健康和休息,才能适当模拟人类行为。如果这些需求不能满足,会产生负面反馈像孤独、疾病、疲惫。

情感是智能体对自身和环境的评价,它们会影响智能体的情绪状态、情绪表达和情绪调节。比如AI智能体感到愤怒时,应该能进行发泄,像跑步或冥想的行为。

亲密关系是智能体与其他智能体或人类之间的社会联系,它们会影响智能体的信任、合作和互动模式。AI智能体也需要根据与其他AI智能体的亲密度调整互动方式。

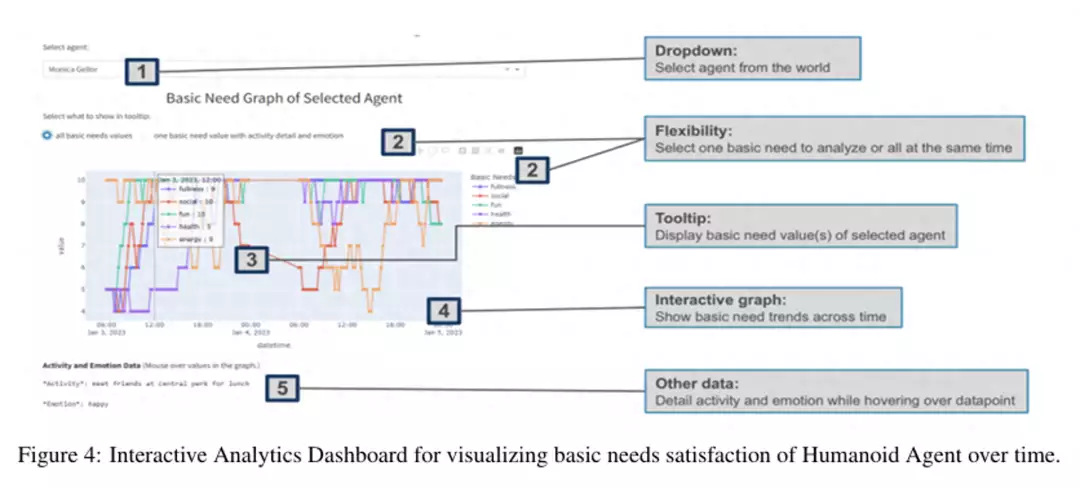

为了行为可视化,研究人员还构建了一个平台,使用Unity游戏引擎实现AI智能化在不同环境中活动(研究人员演示了其中三种环境)。

平台还包括一个交互分析仪表板,显示AI智能体状态随时间变化。

操作过程

具体是该如何操作?

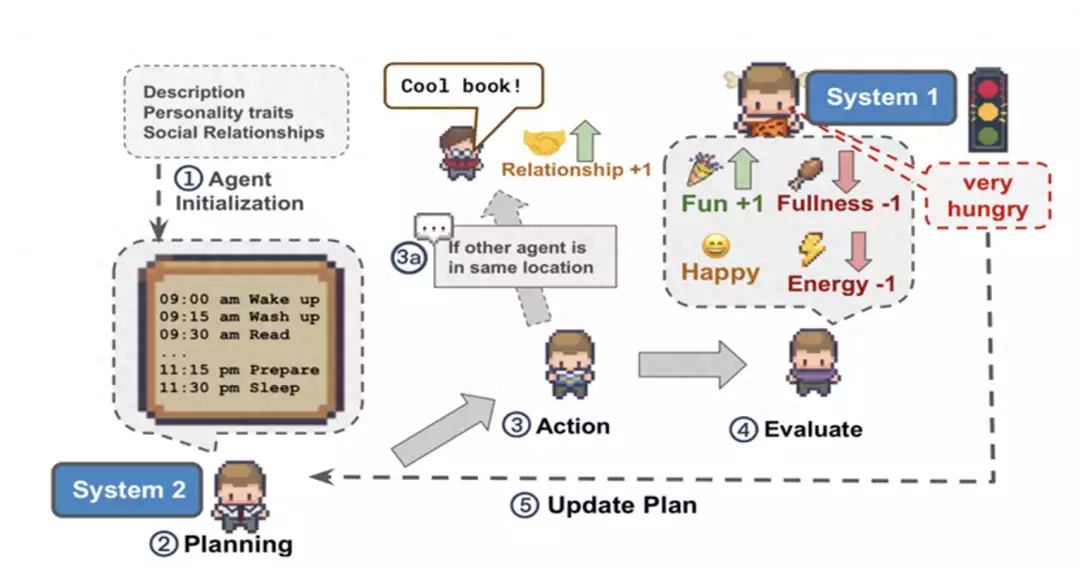

第一步,研究人员首先对AI智能体进行初始设置,如姓名、年龄、性格特点等。例如,John Lin 是柳树市场和药店的药店店主,喜欢帮助别人。

AI智能体的默认情绪设置为中性,共有7种可能:愤怒、悲伤、恐惧、惊讶、快乐、中性和沮丧。

AI智能体的每种基本需求 (充实感、乐趣、健康、社交和能量)都被设置为中等水平(即满分10分中的5分,0分代表完全不能满足他们的需求,10 分代表完全满足该需求) ,只有能量被设置为满分(满分10分中的 10分)。

最后,研究人员为每个AI智能体设置了与其他AI智能体的社会关系,每种社会关系的亲密度字段设置为0至30之间的整数值,其中,低于 5 表示距离较远,5 至 9为相当接近,10 至 14 为接近,15 及以上为非常接近。

第二步,研究人员为AI智能体制定一天内的活动计划,并按小时分解。

在一天开始时,研究人员利用AI智能体的示例日计划、个性特征和描述,首先规划出代理人一天的活动。

然后,一天的计划被递归分解为1小时间隔的计划和15分钟间隔的计划,以证明随着时间推移活动的逻辑一致性。

该计划可根据对环境的观察进行更新。每隔15 分钟,代理将执行其计划中的一项活动,并根据其先前的位置、活动性质以及其世界中的可用位置确定其位置。

但是,AI智能体可以根据其内部状态(即情绪和基本需求)的变化而更新计划。

例如,如果AI智能体目前非常饿,但只计划在 3 小时后吃一顿饱饭,现在就可以在继续当前活动的同时吃点零食。

第三步,促使各智能体之间进行互动和对话。

AI智能体可以根据多种因素(个性、职业、活动等)决定是否对话以及话题结束。

对话结束时,每个AI智能体都将使用对话历史记录来确定他们是否喜欢这次对话如果喜欢,他们与对方的亲密度就会增加1,反之亲密度就会减少1。

AI智能体关系亲密程度逐渐变化(即从相当亲密到亲密的质变需要五分中的一分),足以反映人与人之间的关系是如何随着时间的推移而发展的。

此外,研究人员还利用对话历史记录来确定AI智能体的情绪是否受到对话的影响。

实验结果

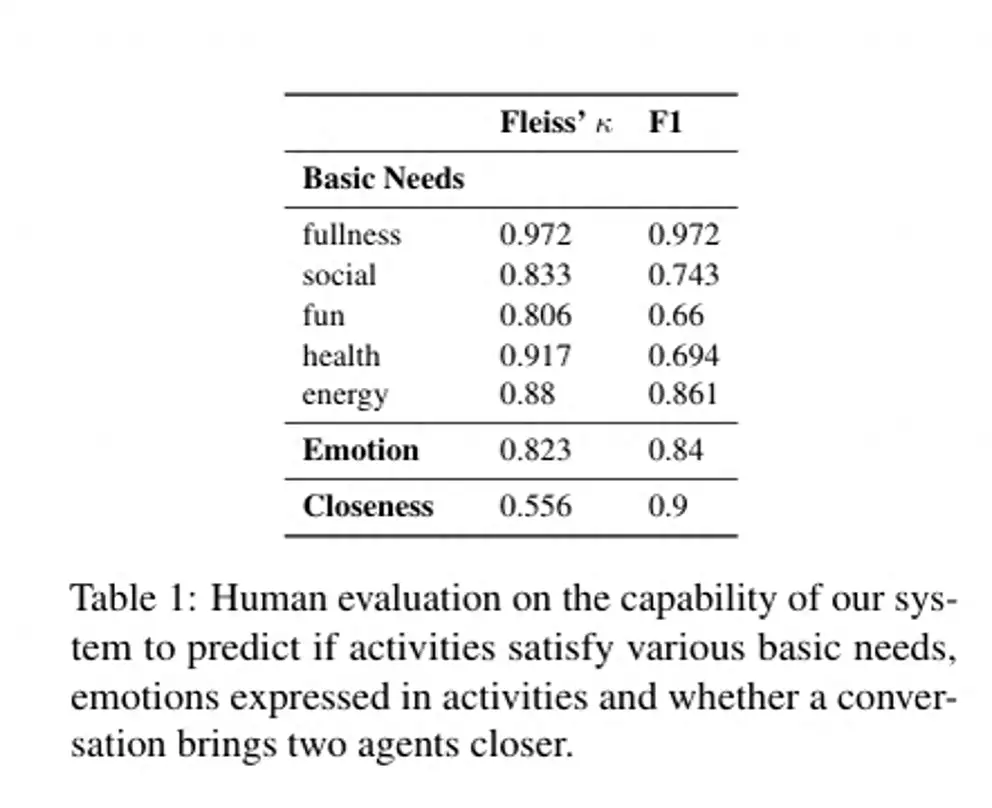

为了评价AI智能体在评估活动和对话对系统各方面的影响时的有效性,研究人员将系统的预测与人类标注进行了比较。

研究发现,Humanoid Agents在对一项活动是否增加饱腹感和能量进行分类时表现良好,但在对活动是否满足了基本的娱乐、健康和社会需求进行分类时表现较差。

一个可能的原因是,系统错误地将与他人用药有关的活动(在药店工作)预测为有助于代理自身的身体健康;将与AI智能体工作有关的普通活动预测为令人愉快的活动(例如,接收教授的反馈或帮助老顾客解决用药需求);将未指定其他AI智能体在场的活动预测为社交活动(例如,整理柜台和展示区或检查库存和补充低库存)。

研究人员指出,使用常识理解能力更强的语言模型有可能缓解这一问题 。

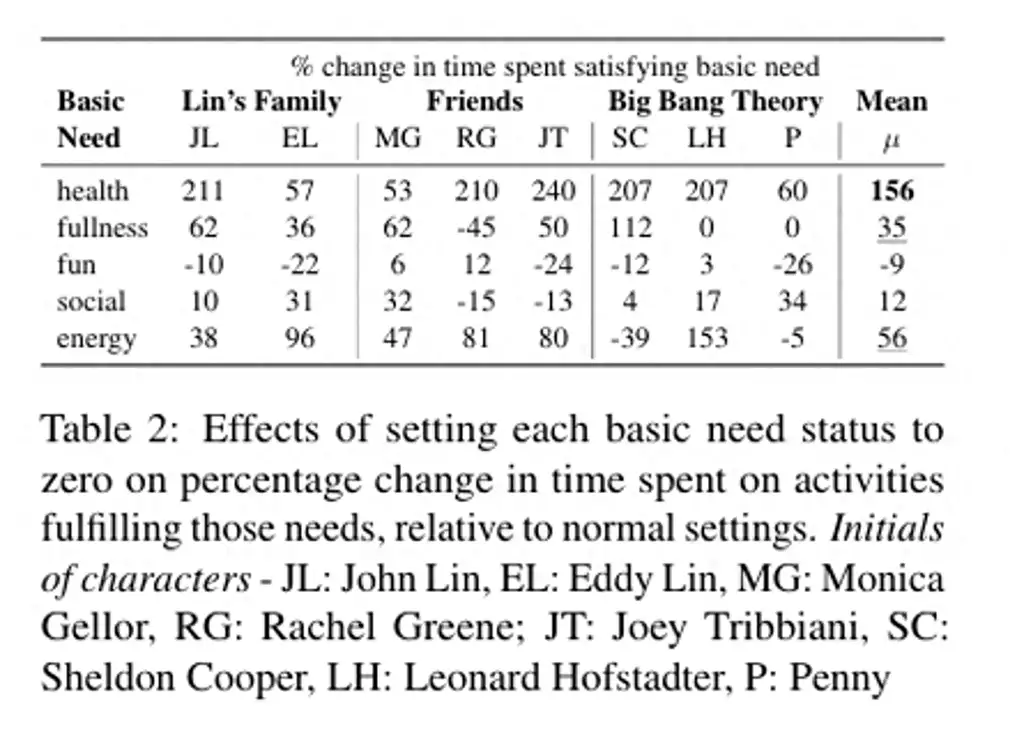

另外,为了研究每个基本需求对AI智能体活动的影响,研究人员模拟了单独设置一个基本需求为零的情况。

研究人员发现,当健康、能量、营养等基本需求被设置为零时,AI智能体对活动的适应程度最高。这证明了这些需求的重要性。

相比而言,当社交需求被设置为零时,AI智能体对活动的调整较小。

一个原因是在正常情况下,AI智能体已经花费大量时间进行社交活动。这表明即使最初将娱乐或社交需求设置为零,其效果也会在一天中逐渐被其他优先事项取代。

总之,通过改变每个基本需求的设置探究了其对AI智能体活动选择的影响,发现生理和安全需求的影响最大。

最后,研究人员认为Humanoid Agents展现为一个有潜力更为准确模仿人类行为和思维的平台。通过考虑“基本需求”、“类人情感”及“人际关系的微妙距离感”,可以更加真实地模拟人类行为。该平台可能对一些在实际环境中难以实施的研究提供帮助。

此前,OpenAI的创始人Sam Altman就曾在多个场合表示:构建庞大AI模型的时代已经结束,AI智能体才是未来的真正挑战。

作者介绍

Zhilin Wang 是一位高级应用科学家,曾经在华盛顿大学攻读研究生,主要研究自然语言处理,尤其是对话系统和计算社会科学。目前在 NVIDIA 的 NeMo NLP 团队工作,方向是让语言模型更有用,更可控,更安全,更易用。

参考资料:

1、https://twitter.com/dotey/status/1713381968530784708

2、https://arxiv.org/pdf/2310.05418.pdf

3、https://github.com/HumanoidAgents/HumanoidAgents

本文 zblog模板 原创,转载保留链接!网址:http://fsxxzx.com/post/101.html

1.本站遵循行业规范,任何转载的稿件都会明确标注作者和来源;2.本站的原创文章,请转载时务必注明文章作者和来源,不尊重原创的行为我们将追究责任;3.作者投稿可能会经我们编辑修改或补充。